當前人工智能之機器學習算法主要有7大類:1)監(jiān)督學習(Supervised Learning),2)無監(jiān)督學習(Unsupervised Learning),3)半監(jiān)督學習(Semi-supervised Learning),4)深度學習(Deep Learning),5)強化學習(Reinforcement Learning),6)遷移學習(Transfer Learning),7)其他(Others)。

今天我們重點探討一下強化學習(RL)。

強化學習(RL),又稱再勵學習、評價學習,是一種重要的機器學習方法,在智能控制機器人及分析預測等領域有許多應用。

那么什么是強化學習?

強化學習是智能系統(tǒng)從環(huán)境到行為映射的學習,以使獎勵信號(強化信號)函數(shù)值最大,強化學習不同于連接主義學習中的監(jiān)督學習,主要表現(xiàn)在教師信號上,強化學習中由環(huán)境提供的強化信號是對產生動作的好壞作一種評價(通常為標量信號),而不是告訴強化學習系統(tǒng)RLS(reinforcement learning system)如何去產生正確的動作。由于外部環(huán)境提供的信息很少,RLS必須靠自身的經(jīng)歷或能力進行學習。通過這種方式,RLS在行動-評價的環(huán)境中獲得知識,改動方案以適應環(huán)境。

通俗的講,就是當一個小孩學習有迷茫或困惑時,如果老師發(fā)現(xiàn)小孩方法或思路正確,就給他(她)正反饋(獎勵或鼓勵);否則就給他(她)負反饋(教訓或懲罰),激勵小孩的潛能,強化他(她)自我學習能力,依靠自身的力量來主動學習和不斷探索,最終讓他(她)找到正確的方法或思路,以適應外部多變的環(huán)境。

強化學習有別于傳統(tǒng)的機器學習,不能立即得到標記,而只能得到一個反饋(獎或罰),可以說強化學習是一種標記延遲的監(jiān)督學習。強化學習是從動物學習、參數(shù)擾動自適應控制等理論發(fā)展而來的。

強化學習原理:

如果Agent的某個行為策略導致環(huán)境正的獎賞(強化信號),那么Agent以后產生這個行為策略的趨勢加強。Agent的目標是在每個離散狀態(tài)發(fā)現(xiàn)最優(yōu)策略以使期望的折扣獎賞和最大。

強化學習把學習看作試探評價過程,Agent選擇一個動作用于環(huán)境,環(huán)境接受該動作后狀態(tài)發(fā)生變化,同時產生一個強化信號(獎或懲)反饋給Agent,Agent根據(jù)強化信號和環(huán)境當前狀態(tài)再選擇下一個動作,選擇的原則是使受到正強化(獎)的概率增大。選擇的動作不僅影響立即強化值,而且影響環(huán)境下一時刻的狀態(tài)及最終的強化值。

若已知R/A梯度信息,則可直接可以使用監(jiān)督學習算法。因為強化信號R與Agent產生的動作A沒有明確的函數(shù)形式描述,所以梯度信息R/A無法得到。因此,在強化學習系統(tǒng)中,需要某種隨機單元,使用這種隨機單元,Agent在可能動作空間中進行搜索并發(fā)現(xiàn)正確的動作。

強化學習模型

強化學習模型包括下面幾個要素:

1) 規(guī)則(policy):規(guī)則定義了Agent在特定的時間特定的環(huán)境下的行為方式,可以視為是從環(huán)境狀態(tài)到行為的映射,常用 π來表示。可以分為兩類:

確定性的policy(Deterministic policy): a=π(s)

隨機性的policy(Stochastic policy): π(a|s)=P[At=a|St=t]

其中,t是時間點,t=0,1,2,3,……

St∈S,S是環(huán)境狀態(tài)的集合,St代表時刻t的狀態(tài),s代表其中某個特定的狀態(tài);

At∈A(St),A(St)是在狀態(tài)St下的actions的集合,At代表時刻t的行為,a代表其中某個特定的行為。

2) 獎勵信號(areward signal):Reward是一個標量值,是每個time step中環(huán)境根據(jù)agent的行為返回給agent的信號,reward定義了在該情景下執(zhí)行該行為的好壞,agent可以根據(jù)reward來調整自己的policy。常用R來表示。

3) 值函數(shù)(valuefunction):Reward定義的是立即的收益,而value function定義的是長期的收益,它可以看作是累計的reward,常用v來表示。

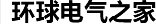

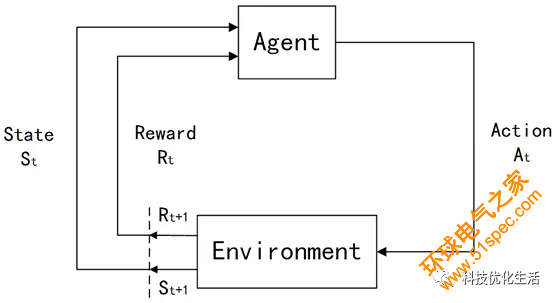

4) 環(huán)境模型(a modelof the environment):整個Agent和Environment交互的過程可以用下圖來表示:

Agent作為學習系統(tǒng),獲取外部環(huán)境Environment的當前狀態(tài)信息St,對環(huán)境采取試探行為At,并獲取環(huán)境反饋的對此動作的評價Rt+1和新的環(huán)境狀態(tài)St+1 。如果Agent的某動作At導致環(huán)境Environment的正獎賞(立即報酬),那么Agent以后產生這個動作的趨勢便會加強;反之,Agent產生這個動作的趨勢將減弱。在強化學習系統(tǒng)的控制行為與環(huán)境反饋的狀態(tài)及評價的反復交互作用中,以學習的方式不斷修改從狀態(tài)到動作的映射策略,達到優(yōu)化系統(tǒng)性能目的。